帮助改进此页面

要帮助改进本用户指南,请选择位于每个页面右侧窗格中的在 GitHub 上编辑此页面链接。

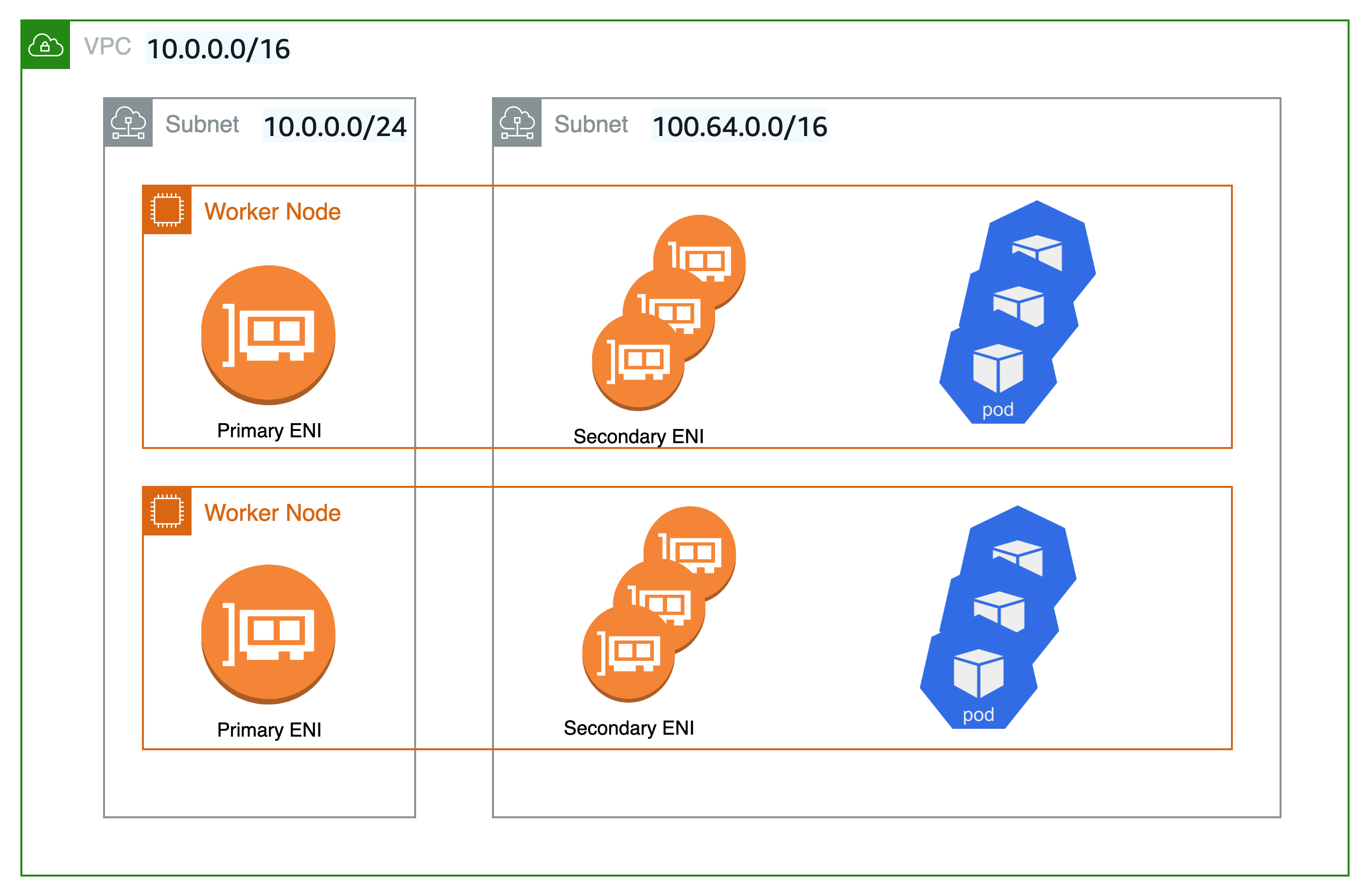

使用自定义网络在备用子网中部署容器组(pod)

适用对象:Linux IPv4 Fargate 节点以及带有 Amazon EC2 实例的 Linux 节点

默认情况下,当适用于 Kubernetes 的 Amazon VPC CNI 插件为 Amazon EC2 节点创建辅助弹性网络接口(网络接口)时,会在与该节点的主网络接口相同的子网中创建它们。它还将相同的安全组关联到与主网络接口关联的辅助网络接口。出于以下一个或多个原因,您可能希望该插件在不同子网中创建辅助网络接口,或者希望将不同的安全组与辅助网络接口关联,或者希望同时实现此两者:

-

主网络接口所在子网中可用的

IPv4地址数量有限。这可能会限制您可以在子网中创建的容器组(pod)数量。通过对辅助网络接口使用不同的子网,您可以增加可用于容器组(pod)的IPv4地址的数量。 -

出于安全原因,容器组(pod)可能需要使用与节点的主网络接口不同的子网或安全组。

-

在公有子网中配置节点,在私有子网中放置容器组(pod)。与公有子网关联的路由表包含指向互联网网关的路由。与私有子网关联的路由表不包含指向互联网网关的路由。

提示

您也可以直接向 Amazon EKS 集群添加新子网或现有子网,而不使用自定义联网。有关更多信息,请参阅 通过管理控制台将现有 VPC 子网添加到 Amazon EKS 集群。

注意事项

以下是使用该功能的注意事项。

-

启用自定义联网后,不会将分配给主网络接口的 IP 地址分配给容器组(pod)。仅会将辅助网络接口的 IP 地址分配给容器组(pod)。

-

如果您的集群使用

IPv6系列,您无法使用自定义联网。 -

如果您计划仅为帮助缓解

IPv4地址耗尽而使用自定义联网,您可以改为使用IPv6系列创建集群。有关更多信息,请参阅 了解如何将 IPv6 地址分配给集群、容器组(pod)和服务。 -

尽管部署到为辅助网络接口指定的子网的容器组(pod)可以使用与节点的主网络接口不同的子网和安全组,子网和安全组也必须与节点位于同一 VPC 中。

-

对于 Fargate,子网通过 Fargate 配置文件控制。有关更多信息,请参阅 定义启动时将使用 Amazon Fargate 的容器组(pod)。