本文属于机器翻译版本。若本译文内容与英语原文存在差异,则一律以英文原文为准。

Debugger 高级演示和可视化

以下演示将引导您了解使用 Debugger 的高级应用场景和可视化脚本。

主题

通过 Amazon SageMaker Experiments 和 Debugger 训练并修剪模型

Nathalie Rauschmayr 博士,Amazon 应用科学家 | 长度:49 分 26 秒

了解 Amazon SageMaker Experiments 和 Debugger 如何简化训练作业的管理。Amazon SageMaker Debugger 可以让训练作业透明可见,并将训练指标保存到 Amazon S3 存储桶中。利用 SageMaker Experiments,您可以通过 SageMaker Studio 将训练信息作为试验调用,并支持训练作业的可视化。这有助于保持高质量的模型,同时根据重要性排名来减少不太重要的参数。

本视频演示模型修剪技术,该技术使预训练的 ResNet50 和 AlexNet 模型更轻、更经济实惠,同时保持高标准的模型精度。

SageMaker AI Estimator 在采用 PyTorch 框架的 Amazon Deep Learning Containers 中,训练 PyTorch Model Zoo 提供的那些算法,而 Debugger 从训练过程中提取训练指标。

视频还演示如何设置 Debugger 自定义规则来观察修剪模型的准确性,在准确性达到阈值时触发 Amazon CloudWatch 事件和 Amazon Lambda 函数,以及自动停止修剪过程以避免冗余迭代。

学习目标如下:

-

了解如何使用 SageMaker AI 加速 ML 模型训练并提高模型质量。

-

了解如何使用通过自动捕获输入参数、配置和结果来管理 SageMaker Experiments 的训练迭代。

-

了解 Debugger 如何通过自动从卷积神经网络的权重、梯度和激活输出等指标中捕获实时张量数据,使训练过程变得透明。

-

当 Debugger 发现问题时,使用 CloudWatch 触发 Lambda。

-

使用 SageMaker Experiments 和 Debugger 全面了解 SageMaker 训练过程。

您可以从 SageMaker PyTorch 迭代模型修剪

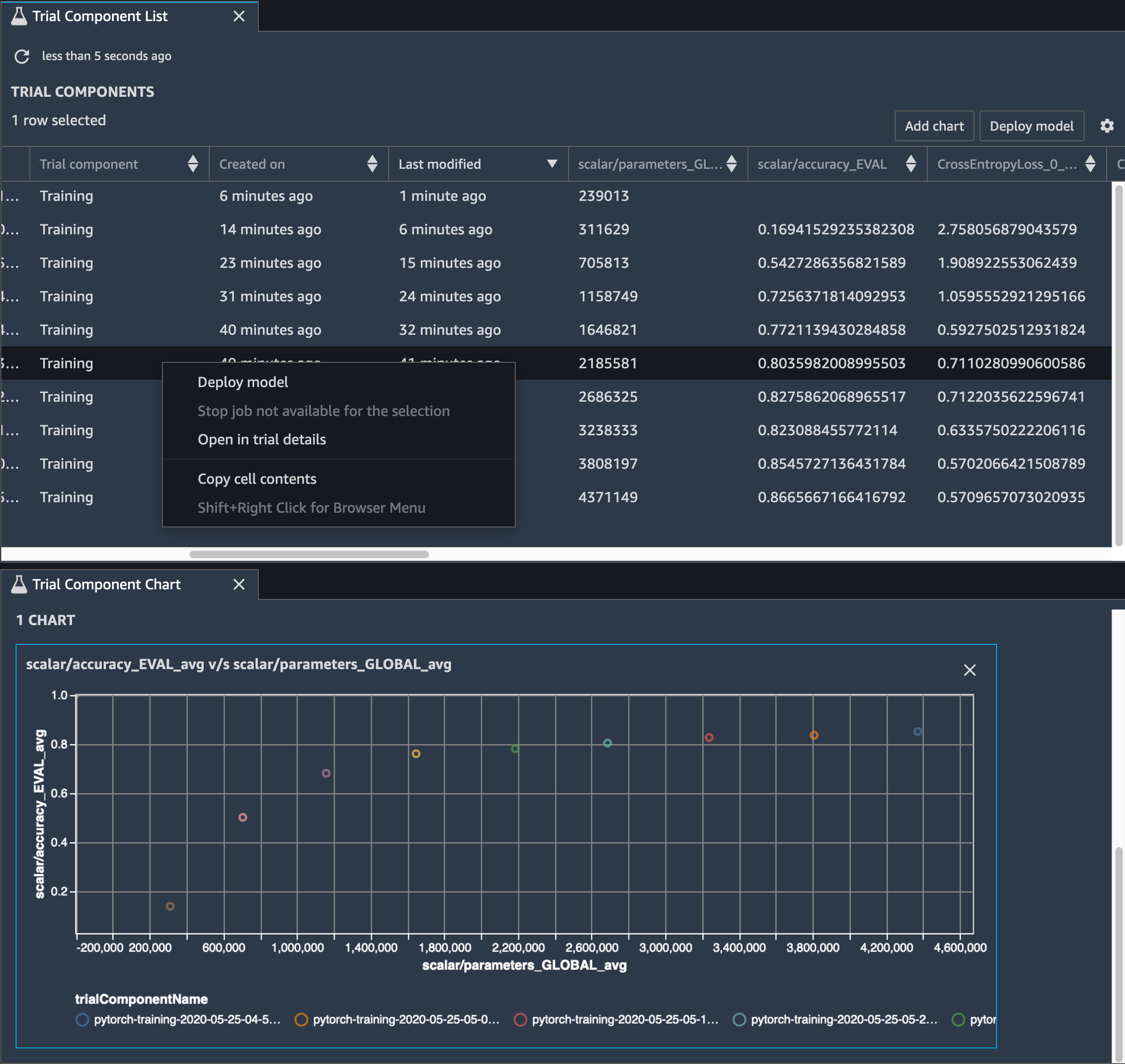

下图显示迭代模型修剪过程如何根据由激活输出和梯度评估的重要性等级来去掉 100 个最不显著的筛选条件,从而减小 AlexNet 的大小。

修剪过程将最初的 5000 万个参数减少到 1800 万个。它还将估计的模型大小从 201 MB 减少到 73 MB。

您还需要跟踪模型准确性,下图显示如何绘制模型修剪过程,以便直观地查看模型准确性基于 SageMaker Studio 中参数数量的变化。

在 SageMaker Studio 中,选择 Experiments 选项卡,选择 Debugger 从修剪过程中保存的张量列表,然后编写试验组件列表面板。选择所有 10 个迭代,然后选择添加图表以创建试验组件图表。在确定了要部署的模型之后,选择试验组件并选择菜单以执行操作,或者选择部署模型。

注意

要使用以下笔记本示例通过 SageMaker Studio 部署模型,请在 train.py 脚本中 train 函数的末尾添加一行。

# In the train.py script, look for the train function in line 58. def train(epochs, batch_size, learning_rate): ... print('acc:{:.4f}'.format(correct/total)) hook.save_scalar("accuracy", correct/total, sm_metric=True) # Add the following code to line 128 of the train.py script to save the pruned models # under the current SageMaker Studio model directorytorch.save(model.state_dict(), os.environ['SM_MODEL_DIR'] + '/model.pt')

使用 SageMaker Debugger 监控卷积自动编码器模型训练

此笔记本演示 SageMaker Debugger 如何在手写数字的 MNIST 图像数据集上,可视化来自无监督(或自行监督)学习过程的张量。

本笔记本中的训练模型是一个带有 MXNet 框架的卷积自动编码器。卷积自动编码器具有瓶颈形状的卷积神经网络,由编码器部分和解码器部分组成。

此示例中的编码器具有两个卷积层,以生成输入图像的压缩表示(潜在变量)。在这种情况下,编码器从大小(28,28)的原始输入图像中生成大小(1,20)的潜在变量,并显著减少训练数据的大小达 40 倍。

解码器有两个解卷积层,并通过重建输出图像来确保潜在变量保留关键信息。

卷积编码器支持具有较小输入数据大小的聚类算法,并可提升聚类算法(例如 k-means、k-NN 和 t-Distributed Stochastic Neighbor (t-SNE) 嵌入)的性能。

此笔记本示例演示如何使用 Debugger 来可视化潜在变量,如下面的动画所示。它还演示 t-SNE 算法如何将潜在变量分为十个聚类并将它们投影到二维空间中。图像右侧的散点图颜色方案反映了真实值,以显示 BERT 模型和 t-SNE 算法将潜在变量组织到聚类中的程度。

使用 SageMaker Debugger 监控 BERT 模型训练中的注意力

来自转换器的双向编码表示 (BERT) 是一种语言表示模型。正如模型名称所反映的那样,BERT 模型建立在用于自然语言处理 (NLP) 的迁移学习和转换器模型之上。

BERT 模型接受了不受监督任务的预训练,例如,预测句子中缺失的单词或预测自然接在前一个句子之后的下一个句子。训练数据包含 33 亿个单词(凭排)的英文文本,如维基百科和电子书籍。对于一个简单的例子,BERT 模型可以高度注意来自主题令牌的适当动词令牌或代词令牌。

预先训练的 BERT 模型可以通过额外的输出层进行微调,以便在 NLP 任务中实现先进的模型训练,例如自动响应问题、文本分类等。

Debugger 从微调过程中收集张量。在 NLP 的上下文下,神经元的权重被称为注意力。

此笔记本演示如何在 Stanford 问答数据集上使用 GluonNLP Model Zoo 中的预训练 BERT 模型

在查询和关键向量中绘制注意力分数和各个神经元有助于识别模型预测不正确的原因。通过使用 SageMaker AI Debugger,您可以检索张量,并在训练进行过程中实时绘制 attention-head 视图,并了解模型正在学习的内容。

下面的动画显示在笔记本示例中提供的训练作业中十次迭代的前 20 个输入标记的注意力分数。

使用 SageMaker Debugger 可视化卷积神经网络(CNN)中的类激活图

本笔记本演示如何使用 SageMaker Debugger,针对卷积神经网络 (CNN) 中的图像检测和分类,绘制类激活图。在深度学习中,卷积神经网络(CNN 或 ConvNet)是一类深度神经网络,最经常用于分析视觉图像。采用类激活图的应用之一是自动驾驶汽车,此应用需要对图像进行即时检测和分类,如交通标志、道路和障碍物。

在该笔记本中,PyTorch ResNet 模型接受德国交通标志数据集

在训练过程中,SageMaker Debugger 收集张量以实时绘制类激活图。如动画图像所示,类激活图(也称为显著图)以红色突出显示具有高激活率的区域。

使用 Debugger 捕获的张量,您可以直观查看激活图在模型训练期间的演变。在训练作业开始时,模型首先检测左下角的边缘。随着训练进行,焦点转移到中心并检测限速标志,模型成功地将输入图像预测为类别 3,这是限速 60km/h 标志的类别,置信度为 97%。