本文属于机器翻译版本。若本译文内容与英语原文存在差异,则一律以英文原文为准。

使用控制台部署编译的模型

如果模型是使用 适用于 Python (Boto3) 的 Amazon SDK、或 Amazon A SageMaker I 控制台编译的 Amazon CLI,则必须满足先决条件部分。按照以下步骤使用 AI 控制台 https://console.aws.amazon.com/ SageMaker SageMaker

主题

部署模型

满足先决条件后,使用以下步骤部署使用 Neo 编译的模型:

-

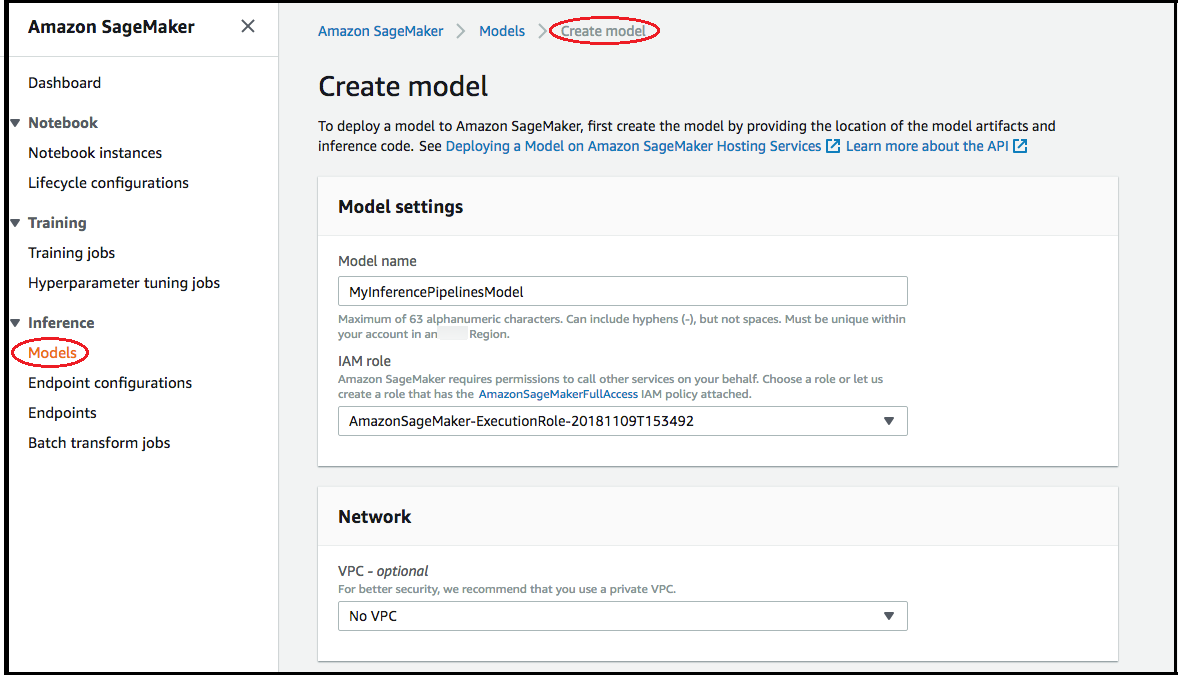

选择模型,然后从推理组中选择创建模型。在创建模型页面上,根据需要填写模型名称、IAM 角色以及 VPC 字段(可选)。

-

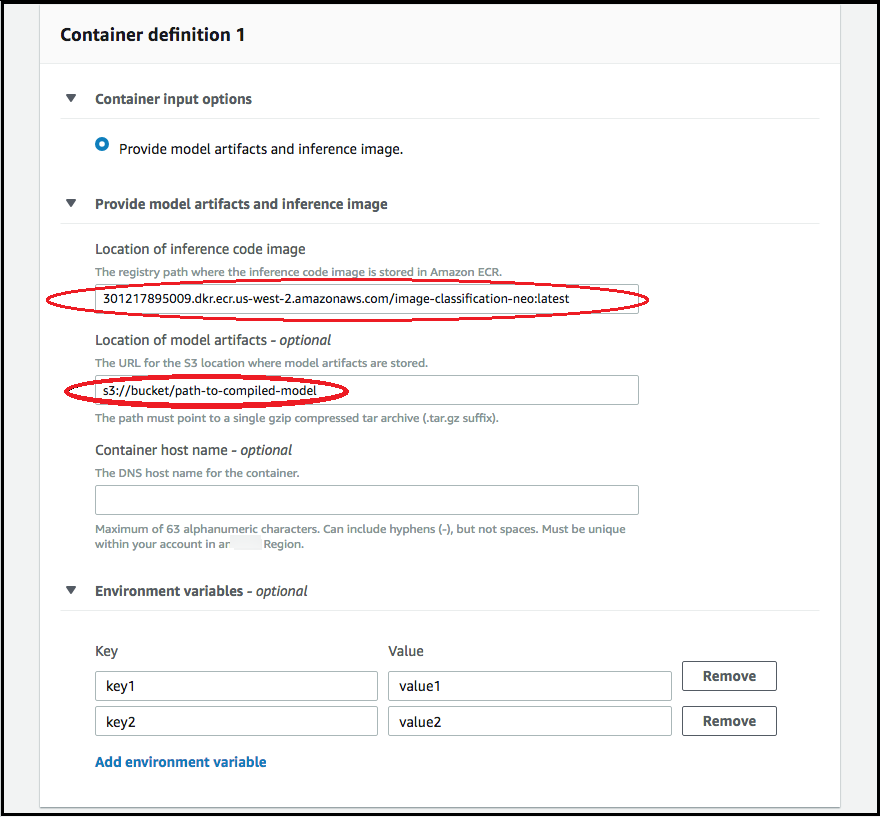

要添加用于部署模型的容器的相关信息,请选择添加容器,然后选择下一步。填写 Container input options (容器输入选项)、Location of inference code image (推理代码映像位置) 和 Location of model artifacts (模型构件位置) 以及可选的 Container host name (容器主机名) 和 Environmental variables (环境变量) 字段。

-

要部署 Neo 编译的模型,请选择以下内容:

-

容器输入选项:选择提供模型构件和推理映像。

-

推理代码映像的位置:根据 Amazon 区域和应用程序类型,从 Neo 推理容器映像中选择推理映像 URI。

-

模型构件位置:输入 Neo 编译 API 生成的、已编译模型构件的 Amazon S3 存储桶 URI。

-

环境变量:

-

将此字段留空SageMaker XGBoost。

-

如果您使用 SageMaker AI 训练模型,请将环境变量指定

SAGEMAKER_SUBMIT_DIRECTORY为包含训练脚本的 Amazon S3 存储桶 URI。 -

如果您没有使用 SageMaker AI 训练模型,请指定以下环境变量:

键 MXNet 和的值 PyTorch 价值观 TensorFlow SAGEMAKER_PROGRAM inference.py inference.py SAGEMAKER_SUBMIT_DIRECTORY /opt/ml/model/code /opt/ml/model/code SAGEMAKER_CONTAINER_LOG_LEVEL 20 20 SAGEMAKER_REGION <您的区域> <您的区域> MMS_DEFAULT_RESPONSE_TIMEOUT 500 对于 TF,将此字段留空。

-

-

-

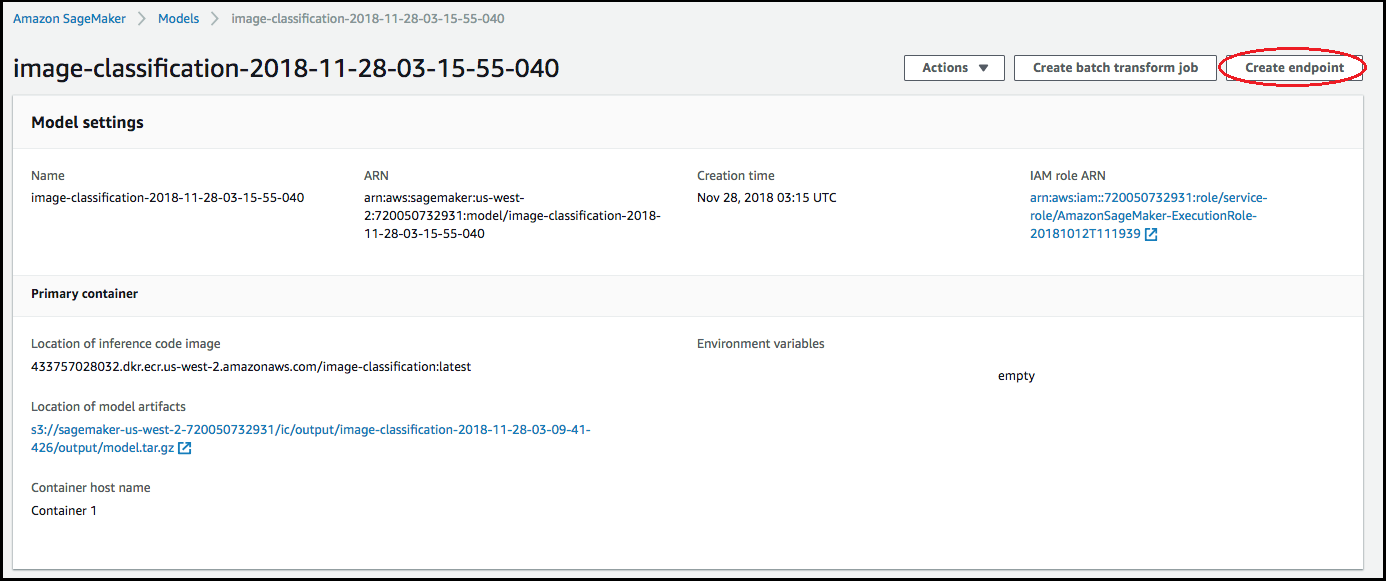

确认容器的信息准确无误,然后选择 Create model (创建模型)。在创建模型登录页面上,选择创建端点。

-

在 Create and configure endpoint (创建和配置端点) 图表中,指定 Endpoint name (端点名称)。对于连接端点配置,请选择创建新端点配置。

-

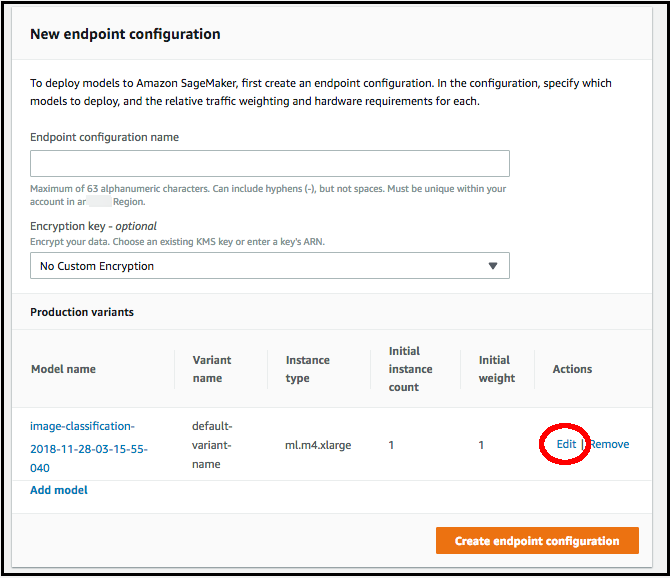

在 New endpoint configuration (新建端点配置) 页面中,指定 Endpoint configuration name (端点配置名称)。

-

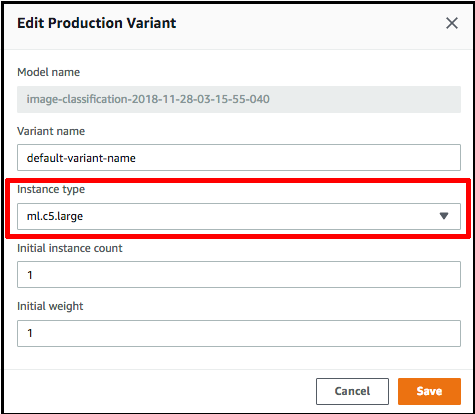

选择模型名称旁的编辑,然后在编辑生产变体页面上指定正确的实例类型。Instance type (实例类型) 值必须与在编译作业中指定的值匹配。

-

选择保存。

-

在新建端点配置页面上,选择创建端点配置,然后选择创建端点。