本文属于机器翻译版本。若本译文内容与英语原文存在差异,则一律以英文原文为准。

推理管道日志和指标

监控对于维护 Amazon A SageMaker I 资源的可靠性、可用性和性能非常重要。要监控推理管道性能并对其进行故障排除,请使用 Amazon CloudWatch 日志和错误消息。有关 SageMaker AI 提供的监控工具的信息,请参阅监控 Amazon A SageMaker I 中的Amazon资源。

使用指标监控多容器模型

要监控推理管道中的多容器模型,请使用 Amazon。 CloudWatch CloudWatch收集原始数据并将其处理成可读的、近乎实时的指标。 SageMaker AI 训练作业和终端节点在AWS/SageMaker命名空间中写入 CloudWatch 指标和日志。

以下各表列出以下内容的指标和维度。

-

端点调用

-

训练作业、批量转换作业和端点实例

维度是唯一标识指标的 name/value 配对。您可以为一个指标分配最多 10 个维度。有关使用进行监控的更多信息 CloudWatch,请参阅亚马逊中的亚马逊 A SageMaker I 指标 CloudWatch。

端点调用指标

AWS/SageMaker 命名空间包含通过调用 InvokeEndpoint 获得的以下请求指标。

指标每 1 分钟报告一次。

| 指标 | 说明 |

|---|---|

Invocation4XXErrors |

模型为其返回 单位:无 有效统计数据: |

Invocation5XXErrors |

模型为其返回 单位:无 有效统计数据: |

Invocations |

发送到模型端点的 要获取发送到模型端点的请求总数,请使用 单位:无 有效统计数据: |

InvocationsPerInstance |

发送到模型的端点调用次数,按每次调用进行归一化 单位:无 有效统计数据: |

ModelLatency |

模型进行响应所需的时间。这包括以下操作所花的时间:发送请求,从模型容器中提取响应,以及完成容器中的推理。ModelLatency 是一个推理管道中所有容器所花的总时间。单位:微秒 有效统计数据: |

OverheadLatency |

在响应 SageMaker AI 向客户提出的开销请求所花费的时间中增加的时间。 单位:微秒 有效统计数据: |

ContainerLatency |

从 SageMaker AI 看来,推理管道容器响应所花费的时间。 ContainerLatency包括发送请求、从模型容器中获取响应以及在容器中完成推理所花费的时间。单位:微秒 有效统计数据: |

端点调用指标的维度

| 维度 | 说明 |

|---|---|

EndpointName, VariantName, ContainerName |

针对指定的端点和指定的变体的 |

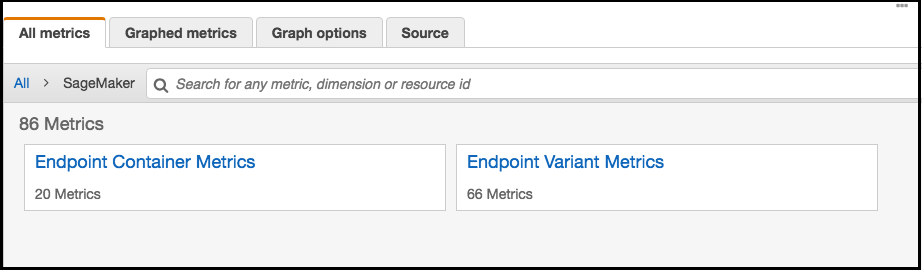

对于推理管道终端节点,将您账户中的每个容器的延迟指标 CloudWatch 列为 SageMaker AI 命名空间中的端点容器指标和端点变体指标,如下所示。该 ContainerLatency 指标仅适用于推理管道。

对于每个端点和每个容器,延迟指标显示容器、端点、变体和指标的名称。

训练作业、批量转换作业和端点实例指标

命名空间 /aws/sagemaker/TrainingJobs、/aws/sagemaker/TransformJobs 和 /aws/sagemaker/Endpoints 包括以下用于训练作业和端点实例的指标。

指标每 1 分钟报告一次。

| 指标 | 说明 |

|---|---|

CPUUtilization |

实例上运行的容器所使用的 CPU 单位的百分比。该值的范围从 0% 到 100%,并乘以的数量。 CPUs例如,如果有四个 CPUs, 对于训练作业, 对于批量转换作业, 对于多容器模型, 对于端点变体, 单位:百分比 |

MemoryUtilization |

实例上运行的容器所使用的内存的百分比。此值范围从 0% 到 100%。 对于训练作业, 对于批量转换作业, MemoryUtilization 是实例上运行的所有容器的所使用的内存总和。对于端点变体, 单位:百分比 |

GPUUtilization |

实例上运行的容器使用的 GPU 单位的百分比。 对于训练作业, 对于批量转换作业, 对于多容器模型, 对于端点变体, 单位:百分比 |

GPUMemoryUtilization |

实例上运行的容器使用的 GPU 内存百分比。 GPUMemory利用率范围从 0% 到 100%,乘以数量。 GPUs例如,如果有四个 GPUs, 对于训练作业, 对于批量转换作业, 对于多容器模型, 对于端点变体, 单位:百分比 |

DiskUtilization |

实例上运行的容器使用的磁盘空间百分比。 DiskUtilization 范围从 0% 到 100%。批量转换作业不支持此指标。 对于训练作业, 对于端点变体, 单位:百分比 |

训练作业、批量转换作业和端点实例指标的维度

| 维度 | 说明 |

|---|---|

Host |

对于训练作业, 对于批量转换作业, 对于端点, |

为了帮助您调试训练作业、终端节点和笔记本实例生命周期配置, SageMaker AI 还会向 Amazon Logs 发送算法容器、模型容器stdout或stderr笔记本实例生命周期配置发送的任何 CloudWatch 内容。您可以使用此信息用于调试并分析进度。

使用日志监控推理管道

下表列出了 SageMaker AI. 发送到 Amazon 的日志组和日志流 CloudWatch

日志流是共享同一来源的一系列日志事件。每个单独的日志源 CloudWatch 构成一个单独的日志流。日志组是一组具有相同保留期、监控和访问控制设置的日志流。

日志

| 日志组名称 | 日志流名称 |

|---|---|

/aws/sagemaker/TrainingJobs |

|

/aws/sagemaker/Endpoints/[EndpointName] |

|

|

|

|

|

|

|

/aws/sagemaker/NotebookInstances |

|

/aws/sagemaker/TransformJobs |

|

|

|

|

|

|

注意

SageMaker 当您使用生命周期配置创建笔记本实例时,AI 会创建/aws/sagemaker/NotebookInstances日志组。有关更多信息,请参阅 使用 LCC 脚本自定义 SageMaker 笔记本实例。

有关 SageMaker AI 日志记录的更多信息,请参阅CloudWatch 亚马逊 A SageMaker I 的日志。